Le mois dernier, Apple a annoncé le déploiement d’ici la fin de l’année aux États-Unis de nouvelles fonctionnalités de protection de l’enfance, dont une fonctionnalité pour analyser toutes les photos que des utilisateurs veulent mettre sur iCloud afin de détecter d’éventuels contenus pédopornographiques identifiés par les autorités. Après des inquiétudes soulevées, Apple a finalement décidé de repousser la mise en œuvre.

» Nous avions précédemment annoncé des plans pour des fonctionnalités destinées à aider à protéger les enfants contre les prédateurs qui utilisent des outils de communication pour les recruter et les exploiter, et à aider à limiter la propagation de contenus relatifs à l’exploitation sexuelle des enfants « , écrit Apple.

» Sur la base des retours de clients, de groupes de défense des droits, de chercheurs et d’autres, nous avons décidé de prendre du temps supplémentaire au cours des prochains mois pour recueillir des commentaires et apporter des améliorations avant de déployer ces fonctionnalités de protection de l’enfance d’une importance cruciale. «

—–

Actualité publiée le 9 août 2021

Apple vient d’annoncer de nouveaux outils afin de détecter des contenus pédopornographiques. Dans le cadre des prochaines mises à jour iOS 15, iPadOS 15, watchOS 8 et macOS Monterey, le déploiement concernera d’abord les États-Unis.

Le groupe de Cupertino met en avant une analyse des photos reçues et envoyées par des comptes de mineurs via son service de messagerie iMessage (elle peut être activée ou désactivée par les parents), une analyse de toutes les photos qui vont être mises en ligne dans iCloud (si iCloud Photos est utilisé), en plus de l’assistant vocal Siri pour alerter sur certaines recherches.

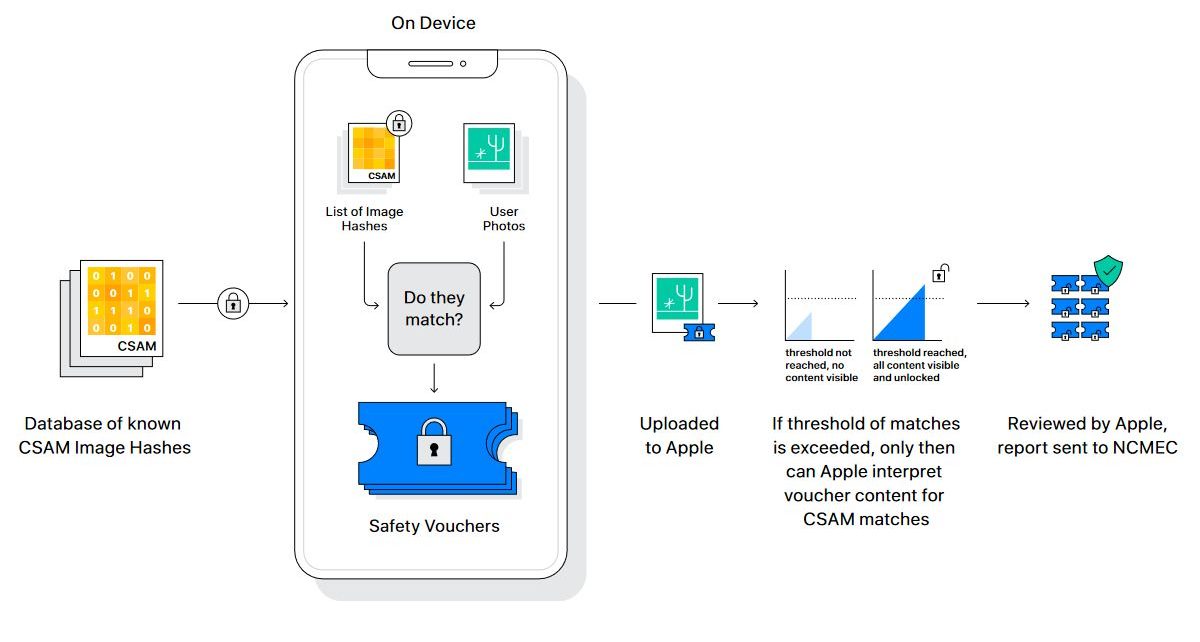

Apple assure que la vie privée des utilisateurs est préservée en soulignant une analyse en local sur l’appareil, une fonction de hachage NeuralHash pour identifier des images d’abus d’enfants stockées sur l’iPhone sans les déchiffrer.

Sur l’appareil, des données de hashs sont confrontées à une base de données d’empreintes numériques d’images pédopornographiques connues fournie par le National Center for Missing and Exploited Children (NMEC).

S’il y a une suspicion, le résultat chiffré d’une correspondance et d’autres informations chiffrées sur une photo sont transmis à Apple. Sur iCloud Photos, une analyse devient alors plus approfondie. Apple indique ne pas être en mesure d’interpréter le contenu, sauf si la correspondance a atteint un certain seuil. Le compte de l’utilisateur pourra être bloqué le cas échéant et avec l’envoi d’un rapport au NMEC.

Une initiative louable pourtant critiquée

Pour l’Electronic Frontier Foundation (EFF), l’initative d’Apple » ouvre une backdoor sur votre vie privée. » En dépit des précautions prises par Apple dont la protection de la vie privée est devenue un véritable argument marketing, l’association fait un parallèle avec des mesures similaires déjà existantes impliquant par exemple la technologie PhotoDNA de Microsoft.

Peu importe le passage par l’analyse en local sur l’appareil pour l’EFF. » Apple peut expliquer en long et en large comment son implémentation technique préservera la vie privée et la sécurité de la backdoor proposée. Au bout du compte, même une backdoor bien documentée, soigneusement pensée et de portée limitée reste une backdoor. «

L’association considère également que le machine learning dédié – et des notifications pour les parents – avec le service de messagerie d’Apple vont dans le sens d’un abandon d’un chiffrement fort.

No matter how well-intentioned, @Apple is rolling out mass surveillance to the entire world with this. Make no mistake: if they can scan for kiddie porn today, they can scan for anything tomorrow.

They turned a trillion dollars of devices into iNarcs—*without asking.* https://t.co/wIMWijIjJk

— Edward Snowden (@Snowden) August 6, 2021

En réaction, le lanceur d’alerte Edward Snowden prévient : » Peu importe les bonnes intentions, Apple déploie une surveillance de masse pour le monde entier. Ne vous méprenez pas : s’ils peuvent rechercher du porno d’enfants aujourd’hui, ils peuvent rechercher n’importe quoi demain. «

Apple savait pertinemment que ses nouveaux outils allaient provoquer des remous et devra poursuivre ses efforts de pédagogie pour toujours jouer la carte du chantre du respect de la vie privée.

L’article Apple reporte ses mesures controversées est apparu en premier sur zimo news.