La pandémie qui a fait rage à travers le monde au cours de l’année écoulée a jeté une lumière froide et dure sur bien des choses – les divers niveaux de préparation à réagir; attitudes collectives à l’égard de la santé, de la technologie et de la science; et de vastes inégalités financières et sociales. Alors que le monde continue de traverser la crise sanitaire de la covid-19 et que certains endroits commencent même un retour progressif au travail, à l’école, aux voyages et aux loisirs, il est essentiel de résoudre les priorités concurrentes de protection de la santé publique de manière équitable tout en garantissant la confidentialité.

La crise prolongée a conduit à un changement rapide du comportement professionnel et social, ainsi qu’à une dépendance accrue à l’égard de la technologie. Il est maintenant plus essentiel que jamais que les entreprises, les gouvernements et la société fassent preuve de prudence dans l’application de la technologie et le traitement des informations personnelles. L’adoption élargie et rapide de l’intelligence artificielle (IA) montre à quel point les technologies adaptatives ont tendance à se croiser avec les humains et les institutions sociales de manière potentiellement risquée ou inéquitable.

«Notre relation avec la technologie dans son ensemble aura radicalement changé après la pandémie», déclare Yoav Schlesinger, directeur de la pratique de l’IA éthique chez Salesforce. «Il y aura un processus de négociation entre les gens, les entreprises, le gouvernement et la technologie; comment leurs données circulent entre toutes ces parties seront renégociées dans un nouveau contrat de données sociales. »

L’IA en action

Alors que la crise de la covid-19 commençait à se dérouler au début de 2020, les scientifiques se sont tournés vers l’IA pour soutenir une variété d’utilisations médicales, telles que l’identification de candidats médicaments potentiels pour les vaccins ou le traitement, la détection des symptômes potentiels de la covid-19 et l’allocation de ressources rares comme intensives. -les lits et ventilateurs des unités de soins. Plus précisément, ils se sont appuyés sur la puissance analytique des systèmes augmentés par l’IA pour développer des vaccins et des traitements de pointe.

Bien que les outils avancés d’analyse de données puissent aider à extraire des informations à partir d’une quantité massive de données, le résultat n’a pas toujours été des résultats plus équitables. En fait, les outils basés sur l’IA et les ensembles de données avec lesquels ils travaillent peuvent perpétuer un biais inhérent ou une inégalité systémique. Tout au long de la pandémie, des agences comme les Centers for Disease Control and Prevention et l’Organisation mondiale de la santé ont rassemblé d’énormes quantités de données, mais les données ne représentent pas nécessairement avec précision les populations qui ont été affectées de manière disproportionnée et négative, y compris les populations noires, brunes et autochtones. les gens – pas plus que certains des progrès diagnostiques qu’ils ont réalisés, dit Schlesinger.

Par exemple, les appareils portables biométriques tels que Fitbit ou Apple Watch se montrent prometteurs dans leur capacité à détecter les symptômes potentiels de la covid-19, tels que les changements de température ou la saturation en oxygène. Pourtant, ces analyses reposent sur des ensembles de données souvent défectueux ou limités et peuvent introduire des préjugés ou des injustices qui affectent de manière disproportionnée les personnes et les communautés vulnérables.

«Certaines recherches montrent que lumière LED verte a plus de difficulté à lire le pouls et la saturation en oxygène sur les peaux plus foncées », explique Schlesinger, se référant à la source de lumière à semi-conducteur. «Donc, il pourrait ne pas faire un aussi bon travail pour attraper les symptômes de covid chez les personnes à la peau noire et brune.»

L’IA a montré une plus grande efficacité pour aider à analyser d’énormes ensembles de données. Une équipe de la Viterbi School of Engineering de l’Université de Californie du Sud a développé un cadre d’IA pour aider à analyser les candidats vaccins covid-19. Après avoir identifié 26 candidats potentiels, il a réduit le champ à 11 qui étaient les plus susceptibles de réussir. La source de données pour l’analyse était la base de données des épitopes immunitaires, qui comprend plus de 600 000 déterminants de contagion provenant de plus de 3 600 espèces.

D’autres chercheurs de Viterbi appliquent l’IA pour déchiffrer plus précisément les codes culturels et mieux comprendre les normes sociales qui guident le comportement des groupes ethniques et raciaux. Cela peut avoir un impact significatif sur la façon dont une certaine population se comporte pendant une crise comme la pandémie, en raison des cérémonies religieuses, des traditions et d’autres mœurs sociales qui peuvent faciliter la propagation du virus.

Les scientifiques principaux Kristina Lerman et Fred Morstatter ont basé leurs recherches sur Théorie des fondements moraux, qui décrit «l’éthique intuitive» qui forme les constructions morales d’une culture, comme la bienveillance, l’équité, la loyauté et l’autorité, contribuant à informer le comportement individuel et de groupe.

«Notre objectif est de développer un cadre qui nous permette de comprendre la dynamique qui anime le processus décisionnel d’une culture à un niveau plus profond», déclare Morstatter dans un rapport publié par USC. «Et ce faisant, nous générons des prévisions mieux informées sur le plan culturel.»

La recherche examine également comment déployer l’IA de manière éthique et équitable. «La plupart des gens, mais pas tous, souhaitent rendre le monde meilleur», déclare Schlesinger. «Nous devons maintenant passer au niveau suivant: quels objectifs voulons-nous atteindre et quels résultats aimerions-nous voir? Comment mesurerons-nous le succès et à quoi ressemblera-t-il? »

Apaiser les préoccupations éthiques

Il est essentiel d’interroger les hypothèses sur les données collectées et les processus d’IA, dit Schlesinger. «Nous parlons d’atteindre l’équité par la sensibilisation. À chaque étape du processus, vous faites des jugements de valeur ou des hypothèses qui pondéreront vos résultats dans une direction particulière », dit-il. «C’est le défi fondamental de la construction d’une IA éthique, qui consiste à regarder tous les endroits où les humains sont biaisés.»

Une partie de ce défi consiste à effectuer un examen critique des ensembles de données qui informent les systèmes d’IA. Il est essentiel de comprendre les sources de données et la composition des données, et de répondre à des questions telles que: Comment les données sont-elles constituées? Comprend-il un large éventail de parties prenantes? Quelle est la meilleure façon de déployer ces données dans un modèle pour minimiser les biais et maximiser l’équité?

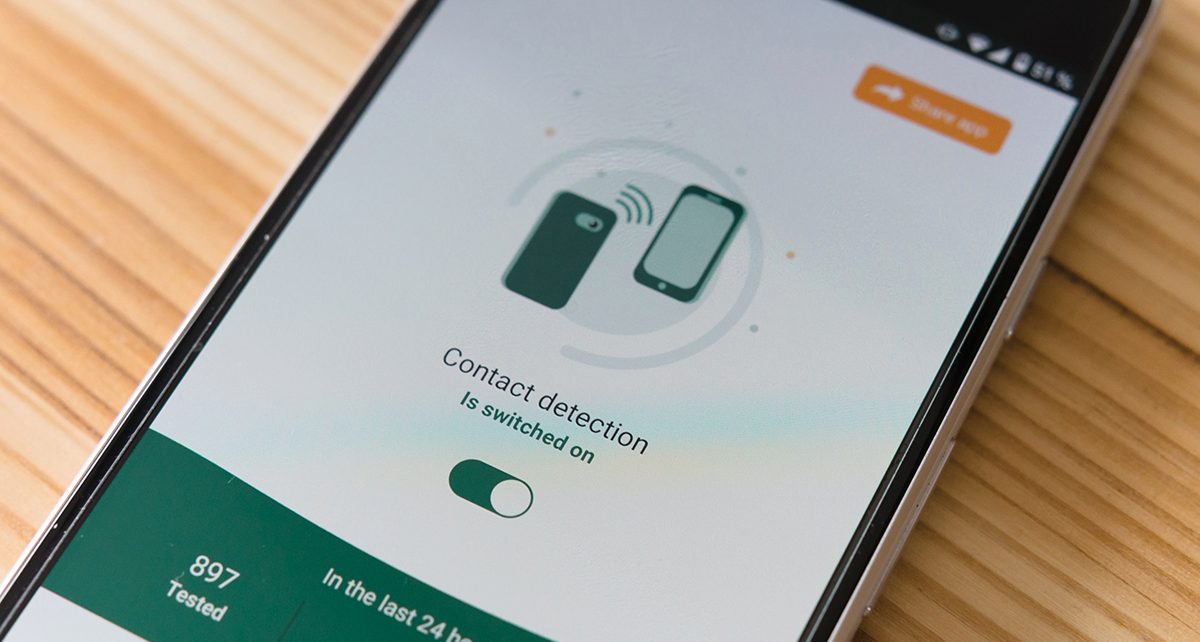

À mesure que les gens retournent au travail, les employeurs peuvent en utilisant des technologies de détection avec IA intégrée, y compris des caméras thermiques pour détecter les températures élevées; des capteurs audio pour détecter la toux ou les voix élevées, qui contribuent à la propagation des gouttelettes respiratoires; et des flux vidéo pour surveiller les procédures de lavage des mains, les réglementations relatives à la distance physique et les exigences relatives aux masques.

De tels systèmes de surveillance et d’analyse présentent non seulement des problèmes de précision technique, mais présentent droits humains, confidentialité, sécurité et confiance. L’impulsion pour une surveillance accrue a été un effet secondaire troublant de la pandémie. Les agences gouvernementales ont utilisé des images de caméras de surveillance, des données de localisation de smartphones, des enregistrements d’achat de cartes de crédit et même des analyses de température passives dans des zones publiques surpeuplées comme les aéroports pour aider à retracer les mouvements de personnes qui pourraient avoir contracté ou été exposées au covid-19 et établir la transmission du virus. Chaînes.

«La première question à laquelle il faut répondre n’est pas simplement de savoir si nous pouvons le faire – mais devrions-nous le faire?» dit Schlesinger. «Le balayage des individus pour leurs données biométriques sans leur consentement soulève des préoccupations éthiques, même si cela se présente comme un avantage pour le plus grand bien. Nous devrions avoir une conversation solide en tant que société pour savoir s’il existe une bonne raison de mettre en œuvre ces technologies en premier lieu. »

A quoi ressemble le futur

Alors que la société revient à quelque chose qui s’approche de la normale, il est temps de réévaluer fondamentalement la relation avec les données et d’établir de nouvelles normes pour la collecte de données, ainsi que l’utilisation appropriée – et potentiellement abusive – des données. Lors de la construction et du déploiement de l’IA, les technologues continueront de faire les hypothèses nécessaires sur les données et les processus, mais les fondements de ces données doivent être remis en question. Les données proviennent-elles légitimement? Qui l’a assemblé? Sur quelles hypothèses repose-t-il? Est-il présenté avec précision? Comment la vie privée des citoyens et des consommateurs peut-elle être préservée?

Comme l’IA est plus largement déployée, il est essentiel de réfléchir à la manière de susciter également la confiance. L’utilisation de l’IA pour augmenter la prise de décision humaine, et non pour remplacer entièrement l’apport humain, est une approche.

«Il y aura plus de questions sur le rôle que l’IA devrait jouer dans la société, sa relation avec les êtres humains, quelles sont les tâches appropriées pour les humains et quelles sont les tâches appropriées pour une IA», dit Schlesinger. «Dans certains domaines, les capacités de l’IA et sa capacité à augmenter les capacités humaines accéléreront notre confiance et notre dépendance. Dans les endroits où l’IA ne remplace pas les humains, mais augmente leurs efforts, c’est le prochain horizon. »

Il y aura toujours des situations dans lesquelles un humain doit être impliqué dans la prise de décision. «Dans les secteurs réglementés, par exemple, comme les soins de santé, la banque et la finance, il doit y avoir un être humain dans la boucle afin de maintenir la conformité», déclare Schlesinger. «Vous ne pouvez pas simplement déployer l’IA pour prendre des décisions en matière de soins sans l’intervention d’un clinicien. Autant nous aimerions croire que l’intelligence artificielle est capable de le faire, elle n’a pas encore d’empathie et ne le fera probablement jamais.

Il est essentiel que les données collectées et créées par l’IA n’exacerbent pas mais minimisent les inégalités. Il doit y avoir un équilibre entre trouver des moyens pour l’IA d’aider à accélérer le progrès humain et social, promouvoir des actions et des réponses équitables et simplement reconnaître que certains problèmes nécessiteront des solutions humaines.

Ce contenu a été produit par Insights, la branche de contenu personnalisé de MIT Technology Review. Il n’a pas été rédigé par la rédaction de MIT Technology Review.

L’article Évolution vers une IA plus équitable est apparu en premier sur zimo news.