Au cours des deux dernières années, Facebook AI Research (FAIR) a travaillé avec 13 universités du monde entier pour assembler le plus grand ensemble de données de vidéo à la première personne jamais créé, en particulier pour former des modèles de reconnaissance d’images en apprentissage en profondeur. Les IA formées sur l’ensemble de données seront mieux à même de contrôler les robots qui interagissent avec les gens ou d’interpréter les images à partir de lunettes intelligentes. « Les machines ne pourront nous aider dans notre vie quotidienne que si elles comprennent vraiment le monde à travers nos yeux », déclare Kristen Grauman de FAIR, qui dirige le projet.

Une telle technologie pourrait aider les personnes qui ont besoin d’aide à la maison ou guider les personnes dans les tâches qu’elles apprennent à accomplir. « La vidéo de cet ensemble de données est beaucoup plus proche de la façon dont les humains observent le monde », explique Michael Ryoo, chercheur en vision par ordinateur à Google Brain et à l’Université Stony Brook de New York, qui n’est pas impliqué dans Ego4D.

Mais les abus potentiels sont clairs et inquiétants. La recherche est financée par Facebook, un géant des médias sociaux qui a récemment été accusé au Sénat de faire passer les profits avant le bien-être des gens, un sentiment corroboré par Examen de la technologie du MITses propres enquêtes.

Le modèle commercial de Facebook et d’autres sociétés Big Tech consiste à extraire autant de données que possible du comportement en ligne des gens et à les vendre aux annonceurs. L’IA décrite dans le projet pourrait étendre cette portée au comportement hors ligne quotidien des gens, révélant les objets autour de la maison d’une personne, les activités qu’elle aimait, avec qui elle passait du temps et même où son regard s’attardait – un degré sans précédent d’informations personnelles.

« Il y a du travail sur la confidentialité qui doit être fait alors que vous sortez cela du monde de la recherche exploratoire et que vous en faites quelque chose qui est un produit », explique Grauman. « Ce travail pourrait même être inspiré par ce projet.

Ego4D est un changement radical. Le plus grand ensemble de données précédent de vidéo à la première personne se compose de 100 heures de séquences de personnes dans la cuisine. L’ensemble de données Ego4D se compose de 3025 heures de vidéo enregistrées par 855 personnes dans 73 endroits différents dans neuf pays (États-Unis, Royaume-Uni, Inde, Japon, Italie, Singapour, Arabie saoudite, Colombie et Rwanda).

Les participants avaient des âges et des origines différents; certains ont été recrutés pour leurs professions visuellement intéressantes, telles que boulangers, mécaniciens, charpentiers et paysagistes.

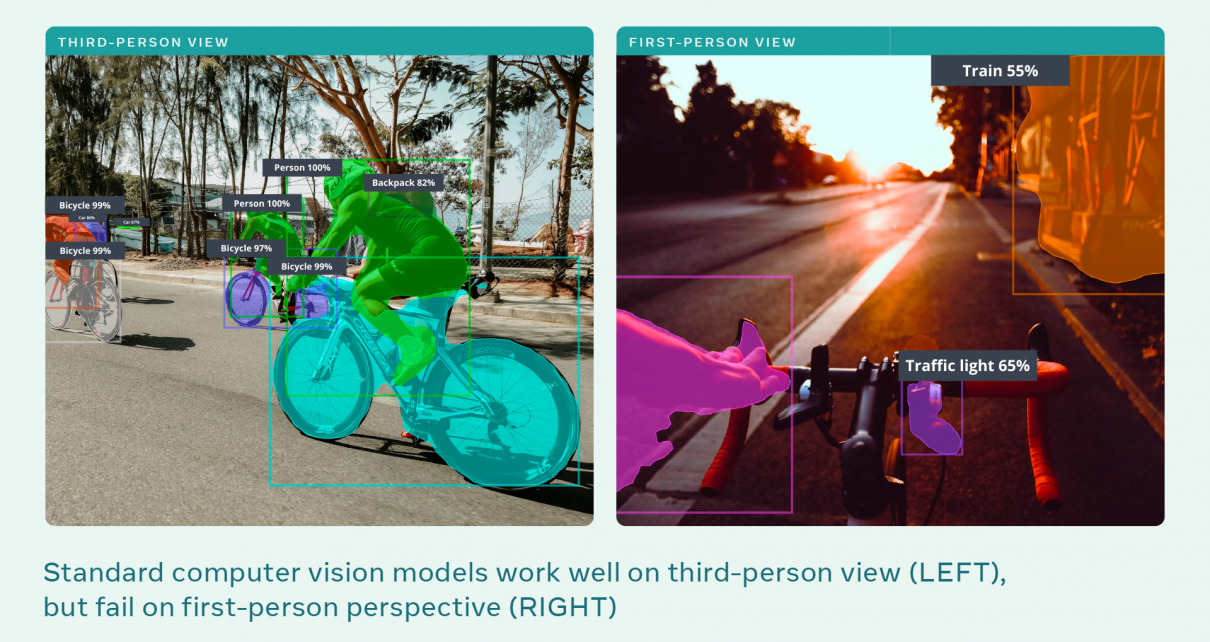

Les ensembles de données précédents se composent généralement de clips vidéo semi-scénarisés d’une durée de quelques secondes seulement. Pour Ego4D, les participants ont porté des caméras montées sur la tête jusqu’à 10 heures à la fois et ont capturé une vidéo à la première personne d’activités quotidiennes non scénarisées, notamment marcher le long d’une rue, lire, faire la lessive, faire du shopping, jouer avec des animaux de compagnie, jouer à des jeux de société et interagir avec d’autres personnes. Certaines séquences comprennent également de l’audio, des données sur l’endroit où le regard des participants était concentré et plusieurs perspectives sur la même scène. C’est le premier ensemble de données du genre, dit Ryoo.

L’article Facebook veut que les machines voient le monde à travers nos yeux est apparu en premier sur zimo news.